Was ist Edge Computing?

Edge Computing ist ein Buzzword, das in letzter Zeit immer häufiger herumgeistert und scheinbar achtlos in Diskussionen eingeworfen wird. Doch was ist es genau? Und was versprechen wir uns von der neuen Technologie? Es wird Zeit, einen etwas genaueren Blick auf das Thema zu werfen.

Rasant steigende Daten-Menge

Wir befinden uns in einer Zeit, in der wir alle permanent Daten produzieren. Diese Menge an Daten nimmt unablässig zu, ja sie explodiert geradezu. Gleichzeitig steigt jedoch die Relevanz von Live-Daten, was zu folgendem Problem führt:

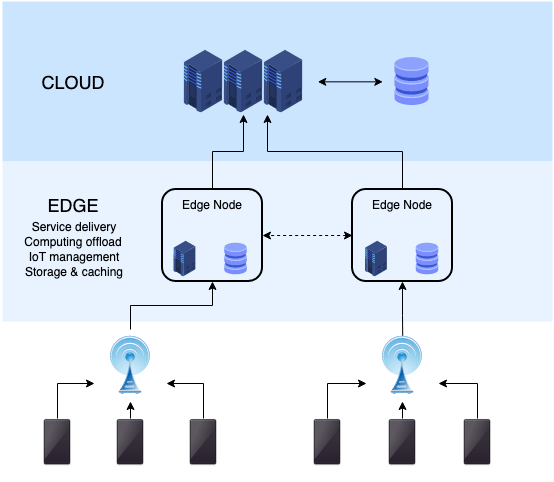

Produzierte Daten werden heute in der Regel in der Cloud verarbeitet. Dies bedeutet, dass die Daten von einem Device an ein konventionelles Rechenzentrum gesendet, dort verarbeitet und wieder zurückgesendet werden. Da diese Datacenter zu weit vom Ort der Erzeugung und Verwendung entfernt sind, um niedrige Latenzzeiten zu garantieren, ist diese Daten-Verarbeitung ein wichtiger Flaschenhals bei der Einführung von neuen Technologien.

Ein sehr anschauliches Beispiel sind selbstfahrende Autos: Die unzähligen Sensoren rund um das Fahrzeug produzieren eine unglaubliche Datenflut. Diese jeweils an ein Datacenter und verarbeitet wieder zurückzuschicken dauert viel zu lange, um das Fahren sicher zu machen.

Die Lösung dieses Problems lautet nun eben “Edge Computing”, also das Verarbeiten dieser Daten am Rand des Netzwerkes.

Wie funktioniert Edge Computing?

Vereinfacht gesagt verarbeitet ein Netzwerk kleinerer Datenzentren (sogenannte “Cloudlets”) einen Teil der entstandenen Daten räumlich näher an der Quelle. Nur der wirklich notwendige Teil der Daten wird an die Cloud weitergesendet. So wird eine Daten-Analyse in Real Time möglich, was Antwort-Zeiten und Bandbreite spart. Dies führt zu weniger Latenz und damit einem deutlich verbesserten Erlebnis für den User.

Bleibt die Frage, was denn genau die “Edge” ist, also wo genau die Organisation und teilweise Verarbeitung stattfindet. Zusammengefasst gesagt: Überall. Auf jedem Device, jedem Sensor und in dezentralen Mini-Datenzentren werden Tasks ausgeführt

Kein Ersatz für die Cloud

Um keine Missverständnisse aufkommen zu lassen: Edge Computing ist nicht als Nachfolge-Konzept zur Cloud gedacht. Vielmehr ist es eine Ergänzung dazu, welche für bestimmte Anwendungsgebiete wie Augmented Reality oder IoT eine wichtige Unterstützung bietet. Oder diese vielleicht sogar erst ermöglicht.

Man könnte sagen, dass Edge Computing die Cloud also nicht ersetzt sondern diese näher zum User bringt, indem die Wege vom Nutzer zur Cloud verkürzt werden. Eine weitere anschauliche Abgrenzung ist folgende: Die Cloud verarbeitet “Big Data”, die Edge “Instant Data”.

Cloud und Edge ergänzen sich also gegenseitig im Sinne einer Arbeitsteilung.

Edge Computing und Augmented Reality

Wie oben erwähnt soll Edge Computing aufsteigenden Technologien dabei helfen, aktuell bestehende Hürden zu überwinden. Dies ist etwas, das gerade auch im Augmented Reality-Umfeld dringend nötig ist.

AR ist mittlerweile kein Hype mehr sondern befindet sich auf dem Weg zum Megatrend. Immer mehr Firmen beginnen, den wahren Nutzen für sich zu erkennen und auf den Zug aufzuspringen. Leider kann die IT-Infrastruktur mit dieser Entwicklung noch nicht ganz mithalten.

Gerade die zeitnahe Verarbeitung der grossen Menge an Bilddaten sorgt vielerorts noch für Probleme. Zu lange Latenzzeiten und Bandbreiten-Probleme erschweren einen flächendeckenden Einsatz vieler Augmented Reality-Anwendungen. In diesem Bereich ist das Dezentralisieren der Daten-Verarbeitung ein wichtiger Faktor für die Hoffnungen auf einen baldigen Durchbruch von AR. Verschwindend geringe Latenzzeiten machen Konzepte wie AR in Alltags-Brillen erst wirklich realistisch.